ChatGPT를 비롯한 LLM(대형 언어 모델)의 등장은 개발 패러다임 자체를 바꿔 놓았다.

이제는 코드를 작성하거나 문서를 요약하는 일을 넘어서 서비스 운영, 정보 검색, 의사 결정 보조까지 모델이 참여할 수 있다. 하지만 현실적인 문제는 많다.

- “모델이 사내 문서를 검색하게 하고 싶다.”

- “LLM이 계산·데이터베이스·외부 API를 이용하도록 하고 싶다.”

- “문서를 유사도 기반으로 검색한 뒤 답변하게 하고 싶다.”

- “대화형 서비스니까 사용자의 이전 맥락을 기억해야 한다.”

이런 기능은 GPT API만으로는 만들기 어렵기 때문에 LangChain이 등장하게 되었다.

LangChain은 LLM을 기반으로 실질적인 애플리케이션을 만들 수 있게 해주는 프레임워크이다. 단순히 챗봇을 넘어서 “지능형 도구”를 만들기 위한 표준 개발 방식이라고 생각하면 된다.

1. LangChain이란?

LLM을 사용한 LangChain은 “LLM + 외부 데이터 + 도구 + 파이프라인을 하나로 엮어주는 프레임워크”이다.

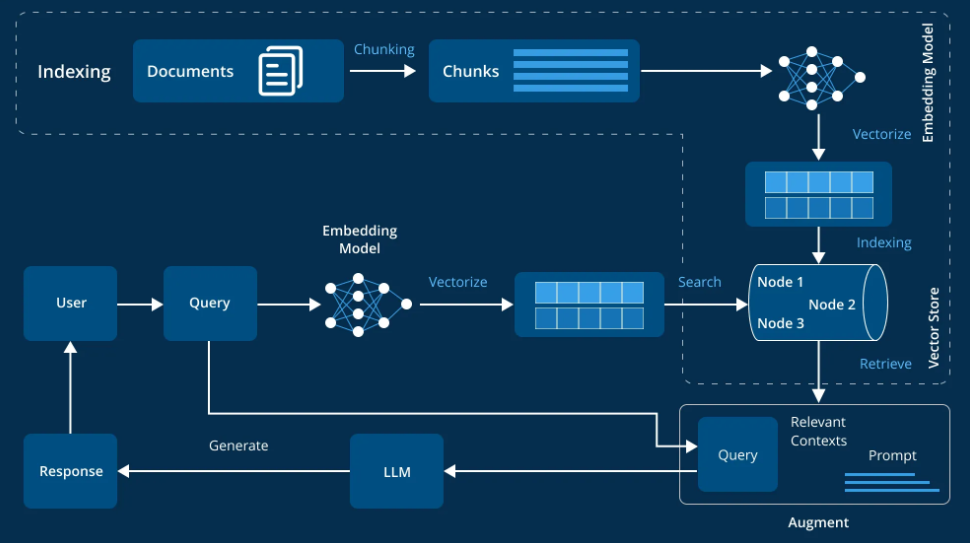

다음 이미지처럼, LangChain은 LLM을 둘러싼 여러 요소를 블록처럼 조합할 수 있는 구조를 제공한다.

이 프레임워크를 통해 개발자는 다음과 같은 작업을 쉽게 설계할 수 있다.

- 긴 문서를 불러와 쪼개고 임베딩 해 검색 가능하게 만들기

- 사용자의 질문을 받아 문서에서 관련 내용을 찾아서 응답하기 (RAG)

- 외부 API, 계산 도구, 데이터베이스 등을 모델이 직접 활용하게 하기 (Agent + Tools)

- 대화의 맥락을 유지하며 답변하도록 하기 (Memory)

- 여러 단계를 연결해 하나의 파이프라인처럼 만들기 (Chains)

이런 기능을 각각 직접 구현하려면 수십~수백 줄의 코드가 필요하지만 LangChain은 이 작업을 표준화 된 인터페이스로 묶어 개발 난이도를 크게 낮춘다.

2. LangChain의 핵심 개념

LangChain은 크게 6개의 핵심 구성 요소로 이루어져 있다.

1️⃣ PromptTemplate

프롬프트를 “재사용 가능한 형태”로 구조화한 것으로 단순 문자열이 아니라 하나의 컴포넌트로 다룬다.

2️⃣ Chain

여러 단계를 이어 붙인 파이프라인이다.

ex) 사용자 질문 → 문서 검색 → 결과 정리 → 모델에게 전달 → 응답 구성

3️⃣ Document Loader / Text Splitter

PDF, 웹페이지, Word, 텍스트 등을 불러오고 LLM이 이해하기 좋게 chunk로 나누는 기능이다.

4️⃣ Embedding + VectorStore

문서 chunk를 숫자 벡터로 바꿔 저장하고 사용자가 질문했을 때 가장 비슷한 문서를 찾아주는 시스템이다. 이것이 흔히 말하는 **RAG(Search 기반 LLM)**의 핵심이다.

5️⃣ Tools

LLM이 사용할 수 있는 외부 기능으로 계산기, DB 조회, 웹 검색, 파일 조작, 코드 실행 등이 있다.

6️⃣ Agent

LLM이 “어떤 도구를 언제 사용할지” 스스로 결정하는 구조로 요즘 많이 언급되는 LLM Agent의 기반이 바로 이 구조이다.

3. LangChain 사용 방법

LangChain의 사용 방법은 크게 3단계로 정리할 수 있다.

1️⃣ LLM을 초기화

어떤 모델을 사용할지 결정한다. (OpenAI, Gemini, Claude, Llama 등 모두 같은 방식으로 관리됨)

2️⃣ 문서, 데이터 준비 → RAG 구성

- 문서를 불러오고

- chunk로 나누고

- embedding을 생성해

- VectorStore에 저장한 뒤

- 검색자(retriever)를 노출한다

이 전체 과정을 몇 줄로 구현할 수 있다는 것이 LangChain의 가장 강력한 장점 중 하나이다.

3️⃣ 프롬프트 / 체인 구성 → 호출

PromptTemplate으로 구조화된 프롬프트를 만들고 LLM과 retriever를 Chain으로 묶어 최종적으로 하나의 “질의 → 응답” 인터페이스를 만든다.

LangChain의 역할은 바로 이 전체 과정을 표준화하고 단순화하는 것이다.

4. LangChain 사용 사례

LLM 기반 서비스를 만들다 보면 이슈가 매우 많다.

모델이 회사 문서를 모르지만 → Document Loader + Embedding + VectorStore + RAG 조합 사용으로 해결할 수 있다.

모델이 도구를 쓰게 하고 싶을 때는 → Tools + Agent를 사용할 수 있다.

여러 단계를 순차적으로 처리하고 싶을 때는 → Chains을,

이전 대화를 기억해야 할 때는 → Memory를,

라우팅(분기), 결과 검증(guardrail), 후처리까지 해야 할 때는 → Output Parser + Chain Router를 사용하면 된다.

즉 LangChain은 “LLM의 약점을 보완하며 실무에서 필요로 하는 기능을 모두 제공하는 프레임워크”이다.

LangChain은 다음과 같은 상황에서 탁월하다.

- 기업 내부 문서를 기반으로 검색 + Q&A 시스템을 만들 때

- PDF, 웹페이지, 문서를 분석해야 할 때

- LLM이 계산, DB, API 등 다양한 도구를 사용해야 할 때

- LLM 기반 자동화 Agent를 만들 때

- 복잡한 파이프라인을 하나의 Chain으로 묶고 싶을 때

- 멀티 모달(텍스트 + 이미지)을 결합하고 싶을 때

반대로, 단순 “프롬프트 → 응답” 수준의 작업만 한다면 LangChain이 필요 없을 수도 있다.

LangChain은 단순한 라이브러리가 아니라 “LLM 애플리케이션을 구성하는 방식”을 정의한 프레임워크이다.

- LLM

- 문서 처리

- VectorStore

- RAG

- Tools

- Agent

- Chains

- Memory

이 모든 요소를 하나로 묶는 공통된 구조를 제공함으로써, 복잡한 LLM 시스템을 안정적이고 재사용 가능한 형태로 구축할 수 있게 해준다.

AI 시대의 소프트웨어는 “문서 기반 검색 + 모델 + 도구 + 자동화”가 결합된 형태로 발전하고 있다. 이 구조를 가장 쉽게 다룰 수 있는 도구가 바로 LangChain이다.